Fortschritte in der künstlichen Intelligenz können sehr beunruhigend sein, insbesondere wenn damit ernsthafte Fragen bezüglich Intimität und Privatsphäre verbunden sind.

Eine Forschungsstudie der Stanford University, die im Economist veröffentlicht wurde, hat für Aufsehen gesorgt, weil sie behauptet, dass künstliche Intelligenz anhand von Bildern erkennen kann, ob eine Person homosexuell oder heterosexuell ist.

LGBTQ-Unterstützungsgruppen und Datenschutzorganisationen haben den Bericht als unwissenschaftlich und irreführend kritisiert. Sie bemängelten den Mangel an Vielfalt, rassistische Vorurteile und die Vereinfachung des Spektrums sexueller Identitäten auf eine binäre Darstellung.

James Heighington, der Chief Digital Officer bei GLAAD, einer LGBTQ-Medienorganisation, betont, dass Technologie nicht dazu in der Lage ist, die sexuelle Orientierung einer Person zu bestimmen. Er forderte die Stanford University und die Medien zusammen mit der HRC auf, die entsprechende Forschung zu beenden.

Der Text besagt, dass die Technologie in der Lage ist, ein Muster zu erkennen, das bei einer kleinen Gruppe von weißen schwulen und lesbischen Personen auf Dating-Websites ähnlich aussieht. Es wird jedoch betont, dass diese Erkenntnisse nicht auf diese spezifische Gruppe beschränkt sein sollten.

Kosinski und Wang haben auf die Pressemitteilung von HRC und GLAAD reagiert, in der diese sie beschuldigten, voreilig ein Urteil gefällt zu haben.

Unsere Ergebnisse könnten möglicherweise nicht korrekt sein. Obwohl es Hinweise gibt, die dagegen sprechen, hoffen wir dennoch, dass wir uns irren. Es ist wichtig zu betonen, dass wissenschaftliche Erkenntnisse nur durch wissenschaftliche Daten und Überprüfungen widerlegt werden können, nicht durch Juristen oder Kommunikationsexperten ohne wissenschaftliche Ausbildung.

Wenn die Ergebnisse falsch sind, hat nur ein Irrtum stattgefunden. Sind die Ergebnisse jedoch richtig, könnten die Vertreter von GLAAD und HRC durch die Missachtung wissenschaftlicher Erkenntnisse die Menschen gefährden, für die ihre Organisationen einstehen.

Der Text handelt von der Studie.

Die Studie, durchgeführt von Michal Kosinski und Yilun Wang, nutzte eine öffentlich verfügbare Stichprobe von 35.326 Bildern von 14.776 Personen, die auf einer bekannten amerikanischen Dating-Website zu finden waren.

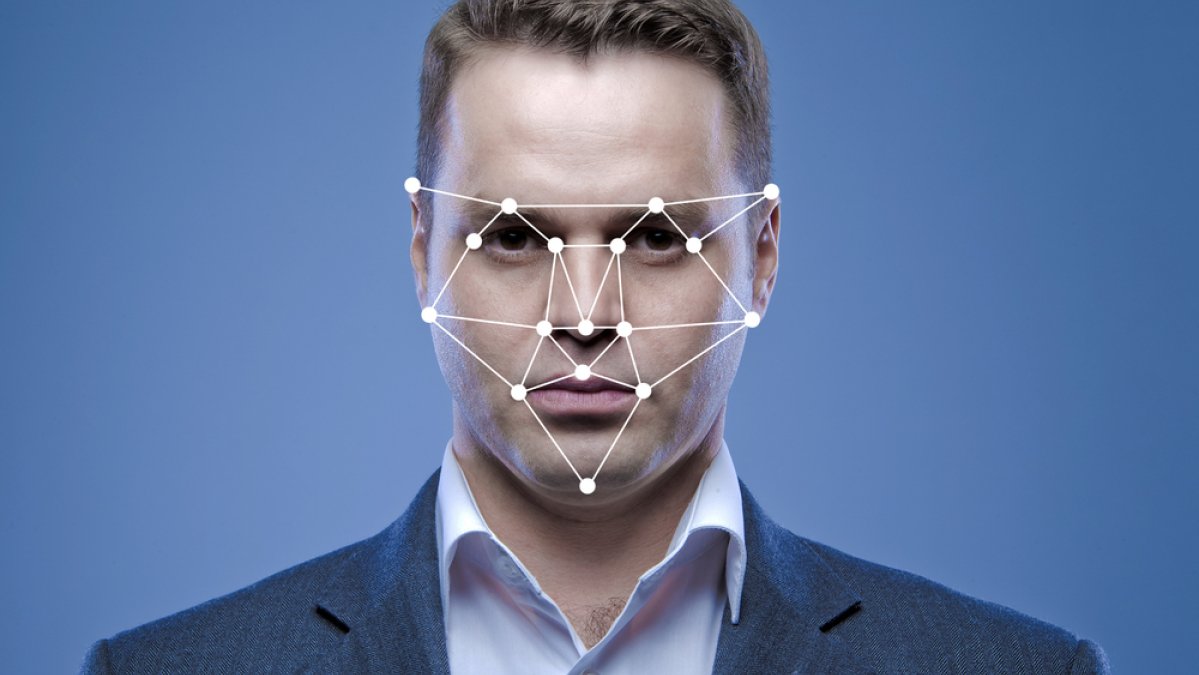

Kosinski und Wang haben einen Algorithmus entwickelt, der mithilfe von “deep neural networks” und Gesichtserkennungstechnologie darauf trainiert wurde, feine Unterschiede in den dauerhaften und vorübergehenden Gesichtszügen von Bildern zu erkennen.

Bei einer Präsentation mit einem zufällig ausgewählten homosexuellen und einem heterosexuellen Teilnehmer konnte das Modell in 81% der Fälle zwischen den Männern und in 74% der Fälle zwischen den Frauen korrekt unterscheiden.

Bei der Überprüfung von fünf Bildern pro Person steigt der Prozentsatz auf 91% für Männer und 83% für Frauen.

In beiden Situationen war die Genauigkeit der Entscheidungen weit höher als die von menschlichen Richtern, die nur in 61% der Fälle bei Männern und 54% bei Frauen korrekt lagen.

Kosinski und Wang entwickelten ihr Modell, basierend auf der pränatalen Hormontheorie (PHT).

Der Text beschäftigt sich mit der Darstellung, Kennzeichnung und Voreingenommenheit aufgrund von Rasse.

Die Studie wirft nicht nur ethische Bedenken bezüglich des Sammelns von Daten aus öffentlichen Dating-Websites auf, sondern auch Fragen zur Darstellung und Kennzeichnung dieser Daten.

Ursprünglich wurden in dem Bericht nur weiße Personen einbezogen, und es wurde angenommen, dass es nur zwei sexuelle Orientierungen gibt – homosexuell und heterosexuell – ohne Berücksichtigung von bisexuellen Personen.

Natürlich ist es offensichtlich, dass dies nur eine kleine Gruppe innerhalb der LGBTQ-Gemeinschaft repräsentiert.

Laut Michael Cook, einem KI-Forscher an der Universität Falmouth, waren alle Beteiligten unter 40 Jahre alt, lebten in Amerika und waren bereit, ihre Präferenzen öffentlich auf einer Website preiszugeben. Cook arbeitet in den Bereichen Spiele, generative Systeme und rechnerische Kreativität.

Diese Gruppe von Menschen ist wahrscheinlich sehr unterschiedlich zu Menschen in anderen Altersgruppen, verschiedenen Ländern und unterschiedlichen romantischen Beziehungen.

Ein zusätzliches Problem, das Cook anspricht, betrifft die Frage, ob die Daten tatsächlich das widerspiegeln, was wir ihnen an Etiketten zuordnen.

Er sagte, dass die Daten analysiert wurden, um festzustellen, ob die Menschen angaben, ob sie auf der Dating-App nach Männern oder Frauen suchen.

Dieser Text besagt, dass die Vereinfachung des Geschlechts- und Sexualitätsspektrums im realen Leben vielen Menschen hilft. Es bezieht sich auch darauf, dass es wichtig ist, Informationen über Bisexuelle, Asexualität und Menschen, die sich noch nicht sicher sind oder eingeschränkt fühlen, ihre sexuellen Vorlieben zu verbreiten.

Dana Polatin-Reuben, Technologieoffizier bei Privacy International, warnt davor, dass ungenaue Forschung die Rechte und sogar das Leben von LGBT-Personen gefährden kann.

Der Forschungsplan basiert auf der stillschweigenden Annahme, dass Geschlechter strikt binär sind, da Personen mit einer nicht-binären Geschlechtsidentität oder sexuellen Orientierung nicht einbezogen wurden, erklärt Polatin-Reuben.

Ein Problem, das auftritt, ist die Voreingenommenheit bei der Auswahl von Daten für die KI-Entwicklung. Oft sind viele KI-Forscher weiß, und daher sind auch die Datensätze oft überwiegend mit weißen Gesichtern gefüllt, was zu einer Verzerrung führen kann.

Forscher tendieren dazu, nur auf diese spezifischen Gesichter Schlussfolgerungen zu ziehen und Systeme zu entwickeln, ohne zu berücksichtigen, dass die Ergebnisse möglicherweise nicht auf Menschen mit unterschiedlichem Aussehen übertragbar sind.

Polatin-Reuben betont, dass es problematisch ist, wenn Forschungsergebnisse nur auf Fotos von weißen Personen basieren. Denn dadurch werden nicht nur diejenigen übersehen, die unter repressiven Regimen leben und am stärksten von Gesichtserkennungsanwendungen betroffen sind, sondern auch LGBT-Personen, die oft Menschen mit anderer Hautfarbe sind.

Kosinski und Wang haben einige der Begrenzungen der Studie erkannt.

Zum Beispiel wird darauf hingewiesen, dass die hohe Genauigkeitsrate nicht bedeutet, dass 91% der Homosexuellen in einer bestimmten Gruppe identifiziert werden können. Dies gilt nur, wenn eines der beiden Bilder bekannt ist und zu einer homosexuellen Person gehört.

In der realen Welt wäre die tatsächliche Genauigkeitsrate wahrscheinlich viel niedriger, wie es eine Simulation mit einer Stichprobe von 1.000 Männern und mindestens fünf Fotos gezeigt hat.

In diesem Beispiel hat das System vermutlich 100 Männer als schwul identifiziert, aber nur 47 davon waren tatsächlich schwul.

GLAADs Heighington kritisierte die Forschung als eine Beschreibung der Schönheitsstandards auf Dating-Websites, die viele Mitglieder der LGBTQ-Gemeinschaft ausschließt, wie zum Beispiel Personen mit verschiedenen Hautfarben, Transgender-Personen, ältere Menschen und andere LGBTQ-Menschen, die nicht bereit sind, Fotos auf Dating-Websites zu veröffentlichen.

Der Schutz von persönlichen Daten und Informationen.

Kosinski und Wang waren so besorgt über die Ergebnisse, dass sie gründlich überlegten, ob es angemessen wäre, diese überhaupt zu veröffentlichen.

Sie sagten, dass ihre Ergebnisse schwerwiegende Datenschutzprobleme aufzeigen, da durch die öffentliche Verfügbarkeit von Millionen von Gesichtsbildern auf Plattformen wie Facebook und Instagram praktisch jeder ohne Einwilligung der Betroffenen eine sexuelle Identifizierung vornehmen kann.

Sie gaben an, dass sie nicht beabsichtigt hatten, die Risiken, über die sie gewarnt hatten, tatsächlich zu aktivieren.

Aber genau das haben sie nach Hillary Rodham Clinton getan.

Ashland Johnson, die Direktorin für öffentliche Bildung und Forschung der HRC, warnt davor, welche schwerwiegenden Folgen entstehen könnten, wenn fehlerhafte Forschung dazu genutzt wird, um ein unterdrückerisches Regime bei der Identifizierung und Verfolgung vermeintlich homosexueller Menschen zu unterstützen.

Die Forscher haben in ihrer Studie festgestellt, dass Regierungen und Unternehmen bereits Praktiken anwenden, die als vorbeugend widersprüchlich betrachtet werden können. Sie möchten Politiker und LGBTQ-Gemeinschaften über die großen Risiken informieren, die entstehen könnten, wenn diese Technologie in die falschen Hände gerät.

Milliarden von Menschen haben ihre Gesichtsbilder in digitalen und traditionellen Archiven hinterlegt, die auf Dating-Plattformen, Foto-Sharing-Websites und Regierungsdatenbanken zu finden sind.

Profilbilder in sozialen Netzwerken wie Facebook, LinkedIn und Google Plus sind standardmäßig für die Öffentlichkeit sichtbar. Überwachungskameras und Smartphones können Bilder von anderen Personen aufnehmen, ohne dass diese ihr Einverständnis gegeben haben.

Nach Cook ist es entscheidend zu untersuchen, ob die Menschen die Papiere tatsächlich verwenden, anstatt nur deren Genauigkeit zu überprüfen. Dies wird als wichtiger Aspekt betrachtet.

Cook sagte, dass es nicht relevant ist, ob ein System funktioniert oder nicht, wenn Unternehmen es nutzen, um den Dienst an Homosexuellen abzulehnen. Diese Handlungsweise sei immer noch falsch und beängstigend.

Diese Technologie macht Menschen wirklich Angst, weil KI und Computer als vertrauenswürdig angesehen werden. Es scheint akzeptabel und wissenschaftlich, Dinge durch einen Computer zu erledigen.

Glaad und das HRC haben vor der Veröffentlichung der Studie ausführlich mit der Stanford University gesprochen, aber ihre Bedenken wurden nicht weiter verfolgt.

Sie haben festgestellt, dass die Behauptungen in den Medien, dass KI anhand eines Fotos des Gesichts erkennen kann, ob jemand schwul ist, tatsächlich ungenau sind.

Aktualisierung vom 28. Mai 2020 um 12:51 Uhr PDT: In diesem Text wurde der Chief Digital Officer von GLAAD fälschlicherweise als Jim Halloran bezeichnet. Nach dem Wunsch von GLAAD wurden alle Verweise auf James Heighington aktualisiert, da James nach seiner Heirat seinen Nachnamen geändert hat. Obwohl James nicht mehr bei GLAAD arbeitet, war er zum Zeitpunkt der Veröffentlichung dort tätig.

Der Text umfasst verschiedene Themen wie künstliche Intelligenz, Cybersicherheit, Gesichtserkennung und LGBTQ.